Von Tim Platner — Unser Autor hat in dem ersten Teil seines spannenden Gastbeitrags im Legal Tech Blog dargestellt, vor welchen Herausforderungen ein Geschädigter und sein Anwalt im Bereich der Schadenregulierung stehen, wie die Schädigerseite die Schadenbearbeitung datenbasiert aussteuern kann und wie hieraus ein strukturelles Ungleichgewicht resultiert. Als Jurist und Geschäftsführer der Legal Data Technology GmbH (VINQO.DE – Legal-Tech-Plattform für Schadensfälle) verfügt Platner über fundiertes Expertenwissen direkt aus der Praxis.

Ein Zwischenfazit des ersten Teils war, dass Bearbeitungsprozesse in der Kanzlei oder beim Legal-Tech-Anbieter erst einmal strukturiert und dann so weit wie möglich von vermeidbaren Prozessschritten bereinigt werden sollten, um so der Prozessgerechtigkeit durch Beschleunigung stärker dienen zu können. Diese wohl eher kreativlosen, aber dennoch unverzichtbaren Schritte sind im ersten Teil stärker beleuchtet worden, sodass wir uns nun dem zweiten wichtigen und eher abstrakteren Aspekt widmen – der Nutzung von Daten auf Geschädigtenseite.

Daten sammeln

Um mit Daten arbeiten zu können, müssen zunächst einmal welche vorliegen. Daten sind im Kern binär codierte Signale. Mehr nicht. Fernab dieser technischen Erklärung, ermöglichen Daten einen unmittelbaren, inhaltlichen Erkenntnisgewinn und einen mittelbaren Meta-Erkenntnisgewinn. Der unmittelbare Erkenntnisgewinn durch Daten ist im Kontext der Schadenregulierung schnell erklärt: Wenn Sie die häufigsten Schadenspositionen durchgehen, angefangen von der Kostenpauschale über die Nutzungsausfallentschädigung, bis hin zu hochstreitigen Positionen wie der Höhe der erstattungsfähigen Sachverständigenkosten oder fiktiven Reparaturkosten, so stehen hinter jeder einzelnen Schadenskategorie unzählige tatsächliche wie rechtliche Erwägungen.

Es kann dann betriebswirtschaftlich sinnvoll sein, unterschiedlich feingliedrige Datenbanken aufzubauen. Dies fängt bei ganz simplen, aber nützlichen Datenbanken, wie der frei verfügbaren ICD-Datenbank an, mit deren Hilfe die ICD-Codes auf Arbeitsunfähigkeitsbescheinigungen oder Arztberichten schneller decodiert werden können. Aber auch eigens gewonnene Erkenntnisse, wie die Überprüfung der vermeintlich günstigeren, häufig aber unzutreffenden Stundenverrechnungssätze der benannten Referenzwerkstätten, lassen sich ohne signifikanten Aufwand hervorragend sammeln und nutzen. Will man es eine Stufe ausgereifter haben, können Echtzeitdaten aggregiert werden. Beispielhaft sind im Falle von vermeintlich zu hohen Mietwagenkosten das automatisierte Abfragen von Angeboten im selben Nutzungszeitraum und in der Region des Mandanten – ein sehr wirksames Argument.

Im Wesentlichen geht es hier darum, anhand von frei verfügbaren oder selbst erstellten Datenbanken die tatsächliche Argumentationsgrundlage zu verbessern und so zwar automatisiert, gleichsam hochgradig einzelfallspezifisch argumentieren zu können. Dabei ist es beeindruckend, wie viele hilfreiche Datenbanken von Bundes- und Landesbehörden zur freien Verwendung zur Verfügung gestellt werden, die bereits dem versierteren Excel-Anwender erhebliche Arbeitserleichterungen bieten können.

Daten managen

Daneben gilt es, das in der Kanzlei angehäufte Wissen zu bündeln und zu managen. Beispielsweise haben wir mehrfach erlebt, dass Versicherer bei einer bestimmten Verletzung im Gesichtsbereich auf ein Urteil verweisen, in dem ein signifikant niedrigeres Schmerzensgeld zugesprochen wurde. Prüft man dieses inhaltlich, wird deutlich, dass bestimmte, schmerzensgelderhöhende Aspekte nicht berücksichtigt worden sind. Damit nun nicht jeder Jurist jedes Mal aufs Neue das Urteil prüfen muss, haben wir dieses in unser System eingespeist. Der Textbaustein wird dann sofort vorgeschlagen und ausgewählt. Im Kfz-Schadenbereich waren die zusätzlichen, coronabedingten Reinigungskosten streitig. Auch hier gibt es zwischenzeitlich Entscheidungen und brancheninterne Einigungen, die es zu kennen und zu nutzen gilt. Auch hier müssen solche Informationen zentral bereitgestellt werden, damit nicht jeder Sachbearbeiter von vorne beginnen muss.

Diese vielen, isolierten Wissenstöpfe beinhalten jedoch nur das in sie “hineingekippte” Wissen. Sie vermögen nur in ihrem eigenen Bereich die hinterlegten Informationen anzuzeigen und wiederzugeben. Dass dies für Juristen schon einen enormen Erkenntnisgewinn bedeuten kann, sagt mehr über die juristische Arbeitsweise de lege arte aus, als über die Wissensdatenbank.

Daten analysieren

Weitaus interessanter, relevanter und leider auch teurer ist es, Daten auszuwerten und miteinander zu verknüpfen. Hierdurch ist nämlich ein eigener, darüberhinausgehender Erkenntnisgewinn möglich. So werden etwa in den einschlägigen Urteilsdatenbanken Paragraphen und Urteile querverlinkt. Hierdurch entstehen Querverbindungen zwischen Daten, die ihrerseits Informationen darstellen. Diese Querverbindungen erbringen keinen unmittelbaren, inhaltlichen Erkenntnisgewinn. Sie stellen Metadaten dar, die jedoch Erkenntnisse ermöglichen, die über den eigentlichen Inhalt hinausgehen. Sie sind also kein “Minus” eines Inhalts, sie sind viel mehr das “Mehr”. Diese Abstraktionsebene ermöglicht den entscheidenden Erkenntnismehrgewinn, der in keiner Wissensdatenbank nachzuschlagen ist.

Während beispielsweise das gewünschte Urteil konventionell nachgeschlagen werden kann, ermöglicht die digitale Version des Urteils und die Verknüpfung des Urteils mit anderen Urteilen einen entscheidenden Wissensvorsprung. Durch die Verknüpfung kann zeitlich, örtlich und instanziell ermittelt werden, welche Gerichte dieses Urteil zitieren. Damit kann der Bearbeiter einschätzen, wie wichtig oder wie etabliert eine Entscheidung in der darauf aufbauenden Rechtsprechung zu einem bestimmten Thema ist. Die Folge: Die eigene Argumentation kann angepasst und präzisiert werden. So kann die Entscheidungstendenz eines Gerichts und sogar einer jeweiligen Kammer zu streitigen Rechtsfragen antizipiert werden – ohne dort bisher eigene Fälle anhängig gehabt zu haben.

Was hat das alles mit Schadenregulierung zu tun? Eine Menge. Für das dargestellte Beispiel erlaubt die Verknüpfung und Auswertung von Daten, systematisch die Prozesschancen zu einzelnen Rechtsfragen zu analysieren und auszuwählen, ob die Klage am Gericht des passivlegitimierten Kfz-Haftpflichtversicherers, des Halters oder – soweit personenverschieden – des Fahrzeugführers anhängig gemacht werden sollte. legal-tech-basierte Kanzleien nutzen diese Erkenntnisse schon längst aus den eigenen Fällen für exakt diese Einschätzung.

Die Metadaten erlauben aber noch viel mehr. Überlegen Sie einmal, wie viele inhaltliche Datenpunkte ein Verkehrsunfallschaden aufweist. Hierzu zählen Fristen, Forderungspositionen, Zahlungen, rechtliche und tatsächliche Ausführungsblöcke uvm. Sie kommen wahrscheinlich auf einige dutzend, vielleicht sogar auf einige hundert Datenpunkte. Überlegen Sie nun, wie viele Metadatenpunkte ein Mandat enthält. Hierzu zählen z.B. Reaktionszeit des Mandanten, der Gegenseite oder des Gerichts, Satz-, Absatz- und Schriftsatzlänge, Anzahl der Beteiligten und Schreiben, Anzahl, Höhe und prozentualer Ausgleich der Forderungen, Dauer des Mandats, Bearbeitungszeit pro Akte, Mitarbeiter, Schriftsatz uvm. Sie werden auf viele tausend Datenpunkte kommen. Ein gigantische Wissensquelle, die in jedem Mandat – unerschlossen – darauf wartet, genutzt zu werden. Dabei lohnt sich die Metadatenanalyse in zigfacher Hinsicht. Neben dem Controlling profitiert auch ganz unmittelbar die Mandatsbearbeitung.

Ein Beispiel: Die Anforderung der Ermittlungsakte ist ein beliebtes Mittel der Versicherung, um als regulierungshemmender Notnagel darauf zu hoffen, dass doch noch ein Haftungseinwand gefunden werden kann, der die eigene Eintrittspflicht abwendet. Die Folge ist eine mehrmonatige Regulierungsverzögerung, obgleich die Rechtsprechung einheitlich ein ums andere Mal betont, dass für die Frage der Regulierungsfrist die Anforderung der Ermittlungsakte unberücksichtigt bleiben muss. Trifft ein solches Schreiben, dass die Ermittlungsakte angefordert worden ist, im Posteingang ein, müssen die weiteren Prozessschritte erwogen werden. Und hier sind Metadaten sinnvoll: Fordert die Versicherung, die Schadenabteilung oder der Sachbearbeiter stets und reflexhaft die Ermittlungsakte an? In wieviel Prozent der (regulierten, abgelehnten, anteilig regulierten) Fälle wurde die Ermittlungsakte angefordert?

Eine Versicherung oder Schadenabteilung, die in nur wenigen Fällen die Ermittlungsakte anfordert, wird man die Prüfung wohl zugestehen und den Mandanten hierüber aufklären. In Fällen, in denen sich die Versicherung reflexhaft in die Akteneinsicht rettet, wird man die Klage und die Erhöhung des Regulierungsdrucks (automatisiert) einleiten. Nur am Rande sei angemerkt: die Daten zur Analyse liegen alle in den Akten. Ob Forderungen voll, anteilig oder überhaupt nicht ausgeglichen worden sind, verrät das strukturierte Forderungskonto. Ob eine Ermittlungsakte angefordert worden ist, ermöglicht die einfache Inhaltsextraktion der Schriftstücke. Kein Mensch muss hier die Akten aufbereiten, um Erkenntnisse gewinnen zu können. Und der Allheilsbringer KI ist hier ebenfalls nicht erforderlich.

Ein Beispiel aus unserer Praxis: Die Gegenseite ist durch ihre schnelle Antworten bekannt. Auf eine Nachfristsetzung erfolgt keine Reaktion. Anhand der Metadaten (Zeit zwischen Ausgang und Eingang der Korrespondenz sowie Datum der Schriftsätze) wurde deutlich, dass es sich hierbei um ein signifikantes Abweichen handelt. Anhand dieser Prozessanomalie wurde ausnahmsweise die telefonische Kontaktaufnahme avisiert. Denn anders als beim nicht skalierbaren, turnusmäßigen Abtelefonieren können durchschnittliche Bearbeitungszeiten mithilfe von Metadaten sehr gut antizipiert werden. Das für beide Seiten nervige Nachfragen, das Überschneiden von Anrufen und Poststücken etc. kann hier auf ein absolutes Minimum reduziert werden. Es stellte sich heraus, dass dem Sachbearbeiter Schriftstücke nicht vorgelegt worden sind – passiert. Nach Neuübersendung erfolgte ein Tag später die Auszahlung.

Ein letztes Beispiel, weil die Erkenntnis so wichtig ist: In einem Schadensfall war die Haftungsquote hochstreitig. Die gut situierte Mandantschaft wäre ohne jedes Zögern bereit gewesen, den Prozess zu finanzieren, über alle Gutachten und Instanzen hinweg, es ging um das, nicht selten zu einem inneren Zucken führende, “Prinzip”. Uns lagen Metadaten über das Regulierungsverhalten des konkreten Gegners vor, wodurch eine hohe Kompromissbereitschaft ersichtlich war. Dadurch war es statistisch wahrscheinlich, dass es sich noch lohnte, außergerichtliche Regulierungsgespräche zu führen, die im Ergebnis sodann auch erfolgreich waren und nicht nur für die eigene Mandantschaft, sondern auch für die Gegenseite viele tausend Euros sparten.

Ein anderer Schaden, selber Gegner, andere Schadenabteilung. Hier waren die Metadaten hochdifferenzierend abweichend. Hier lohnt es sich fast nicht, die Ansprüche außergerichtlich geltend zu machen. So konnten wir von Beginn an den Mandanten über die zu erwartenden Schwierigkeiten informieren und mit dem ersten Schreiben die Deckungszusage einholen. Hierdurch verschieben sich die Erwartungen des Mandanten: wäre er vielleicht vorher geneigt gewesen, die mangelnde Durchsetzung seiner Ansprüche dem Anwalt oder Rechtsdienstleister zuzuschreiben, so ist ihm durch die bereits noch vor Erhalt der Rückmeldung zutreffende Einschätzung des gegnerischen Verhaltens bewusst, dass der Gegner, wie angekündigt, ursächlich für die Verzögerungen ist.

Damit sollen zwei Aspekte deutlich werden:

- Die datengestützte Schadenregulierung auf Geschädigtenseite führt zu einer viel effektiveren und gleichzeitig effizienteren Prozesssteuerung. Anders, als häufig heraufbeschworen, führt Legal Tech nicht zu einem Übergehen des Einzelfalls zugunsten eines auftürmenden Textbausteingeflechts, wie einige wenige Berufungsabweisungen in den Dieselverfahren weismachen könnten. Das Gegenteil ist der Fall. Die Prozesse können datenbasiert weitaus intelligenter, feingliedriger und einzelfallspezifischer ausgewählt und abgestimmt werden. Und weil hierbei nicht das Bauchgefühl, sondern die Faktenlage für die Entscheidung maßgeblich ist, können solche Einzelfallentscheidungen sogar automatisiert erfolgen.

- Aus dieser datenbasierten Differenzierung sollte das schon im ersten Teil angesprochene, erreichbare Ziel der Prozessgerechtigkeit deutlich werden. Der aus meiner persönlichen Sicht schöne Effekt dabei ist, dass hiervon alle Beteiligten, auch die redliche Schädigerseite, profitieren können.

Es werden dort noch einmal außergerichtliche Verhandlungen initiiert, wo vorangegangene Daten einen Erfolg nahelegen oder zeitliche Zugeständnisse gemacht, wo andernfalls (automatisiert) die Abwehr der Akteneinsicht und die Erhöhung des Regulierungsdrucks veranlasst worden wären. Da, wo Versicherer wirklich Zeit brauchen, sollen sie diese auch im allseitigen Interesse zugestanden bekommen.

Unredliches Regulierungsgebaren in Form von obligatorischer Akteneinsichtnahme, organisierter Regulierungsverzögerung und dem turnusmäßigen Wegklicken der Nachfristsetzung kann hingegen mit aller Konsequenz begegnet werden. Dort, wo Versicherer, bis runter auf die Bearbeitungsebene, ihrer originären Aufgabe der Schadenregulierung nicht nachkommen, gilt es unnötige Verzögerungen im Sinne des Mandanten abzukürzen und Strategien abzuändern.

Bevor die Praktiker schreien – oder besser gesagt schreiben: Die wohl unbestreitbar nützliche, datenbasierte Tätigkeit hat ein wohl ebenso unbestreitbar durchgreifendes Problem: die Daten lassen sich mit gängigen Kanzleiprogrammen nicht nutzbar machen. Die Justizverwaltung hat nur für die Metadaten der Bearbeitungsdauer mit “PEPP§Y” ein riesiges Erfassungsprogramm aufgesetzt, in dem mittels handschriftlich zu füllender Erfassungsbögen die durchschnittliche Arbeitszeit abgebildet werden soll. Ein in mehrfacher Hinsicht zum Scheitern verurteiltes Unterfangen.

Die Daten in einem ersten Schritt zu analysieren und im zweiten Schritt zu nutzen, wird einer Kanzlei, bis hoch zur Mittelstandsspitze, regelmäßig aufgrund des Initialaufwands kaum wirtschaftlich möglich sein. Das (noch) geltende Eigenkapitalverbot erschwert die Eigenentwicklung, wobei selbst mit Eigenkapital die Durchführung der Entwicklung noch einmal ein ganz eigenes, spätestens hier nicht selten scheiterndes Kapitel darstellt. Rühmliche Vorreiter wie GanselRechtsanwälte sind hier einmal ausgenommen. Wir können diese Software überhaupt nur entwickeln und weiter vorantreiben, weil wir als Rechtsdienstleister Fremdkapital akquirieren konnten und können.

Allerdings lehrt die Rückschau, dass Spitzentechnologie mit der Zeit erschwinglicher wird – was auch immer dies im Kontext von durchschnittlich sechs- bis siebenstelligen Entwicklungskosten bedeuten mag.

Doch: vor Spitzentechnologie kommt Grundlagentechnologie

Legal Tech mit Kanzleien zu besprechen ist hochspannend, häufig erwachsen nämlich genau solche Metadatenanalysen als Wünsche der Managing Partner aus den Gesprächen, um dem Wettbewerber oder Gegner einen Schritt voraus sein. Weniger spannend, aber unverzichtbar, sind die technisch-konzeptionellen Grundlagen. Denn der Teufel steckt im technisch-konzeptionellen Detail. Wenn Kanzleien beispielsweise Anspruchsschreiben und Anlagen faxen, in der Hoffnung, damit den Zustellungsnachweis führen zu können, so gehen damit hausgemachte Probleme nicht nur hinsichtlich der Lesbarkeit sondern auch der datenschutzrechtlichen Mindeststandards einher.

Damit soll deutlich werden: Wenn Legal Tech in der Praxis und insbesondere in der Schadenregulierung eingesetzt werden soll, sollten und müssen viele, ganz grundsätzliche Aspekte berücksichtigt werden. Die Themen und das erforderliche Problembewusstsein sind zugegeben tiefergehend, aber unbedingt erforderlich. Legal Tech scheitert sonst schon am “Brot und Butter”-Geschäft. Dass dies aufwändig, teuer und aktuell nur einer kleinen Gruppe gut finanzierter Kanzleien / Legal Techs vorbehalten ist, kann, muss und wird sich ändern.

Daten teilen (?)

Ein Ausblick, der hochspannend weil kontrovers ist: das kanzleiübergreifende Teilen von Metadaten aus Mandaten. Während Wissensdatenbanken wie beck-online, juris oder Otto Schmidt online etabliert sind und unverzichtbare unmittelbare Daten enthalten, sind Wissensdatenbanken mit mandatsrelevanten Metainformationen – der Autor lässt sich hier gerne eines Besseren belehren – nicht existent. Dies liegt nicht zuletzt daran, dass die Metadatenanalyse an sich schon nur einem privilegierten Kreis vorbehalten bleibt, denn konventionelle Kanzleisoftware aus den 90er Jahren kann diese Daten schon nicht strukturiert bereitstellen. Selbst wenn dies gelänge, so verbleibt dann noch die Analyse der Metadaten.

Macht man sich die versicherungsübergreifend gebildeten und wachsenden Datenpools (HIS, ControlExpert, Actineo uvm.) bewusst, so werden in diese Daten eingemeldet und erst dort analysiert. Die Aufgabe der Datenbankverwender besteht insoweit nur in der Datenübergabe, die Datenanalyse wird als externer Dienst erst dort vorgenommen. Die analysierten Daten können dann aufbereitet abgerufen werden. Hierdurch reduziert sich der Individualaufwand für die Nutzer deutlich. Dies wäre als praktikabler Ansatz auch auf Geschädigtenseite gut vorstellbar.

Der besondere Reiz am Austausch von Metadaten ist, dass diese Daten jeweils in Echtzeit ausgetauscht, abgeglichen und so aktualisiert werden können. Zudem erweitert sich die Ergebnismenge hierdurch enorm, um Ungenauigkeiten, Einzelfälle und Anomalien besser erkennen und filtern zu können. Bei der Nutzung von Navigationssoftware mit Echtzeit-Staumeldung sind Nutzer beispielsweise bereit, die eigenen Standortinformationen anonymisiert zu teilen, damit das Verkehrsgeschehen anhand der vielen Einmeldungen von Verkehrsteilnehmern in Echtzeit abgebildet und so im Eigeninteresse Staumodelle gebildet werden können, die es ermöglichen, Fahrtzeiten zu präzisieren und Alternativrouten anzubieten.

Metadaten kämen – anders als Falldaten – wenigstens noch grundsätzlich infrage, um als anonymisierter Datensatz geteilt werden zu können. Der Datenschutzexperte wird hier überzeugend einwenden können, abhängig vom Umfang der Metadaten sehr wohl das einzelne Mandat erkennen zu können. Zudem dürfte es bis zur wenigstens partiellen Akzeptanz in der Anwaltschaft noch länger dauern, wenn man die teilweise diffusen Vorbehalte gegenüber Clouddiensten vernimmt, gleichzeitig aber im Wochenrhythmus kontaminierte doc-Dateien von Kanzleien und Notariaten zugeschickt bekommt.

Hier muss die angestrebte Lösung wohl Anwendervorteile so stark integrieren, dass dem trade-off im Prinzip nicht mehr ausgewichen werden kann, wenn der eigene Mandant im Vergleich nicht wesentliche Nachteile erleiden soll. Geschädigte dürften wohl bereit sein, derartige Daten anonymisiert zu teilen, wenn dadurch eine schnellere oder erfolgreiche Durchsetzung ihrer Ansprüche ermöglicht wird.

Fazit

Halten wir für die Prozessgerechtigkeit der Schadenregulierung fest: Prozesse strukturieren und automatisieren, Datenbanken aufbauen, Metadaten analysieren nutzen. Hierbei sind Legal Tech Lösungen unverzichtbar und werden ein immer wichtigeres Differenzierungsmerkmal im harten Wettbewerb um Partner und Geschädigte werden, weil sie die Benchmark in puncto Geschwindigkeit und Effizienz verschieben.

Der Autor

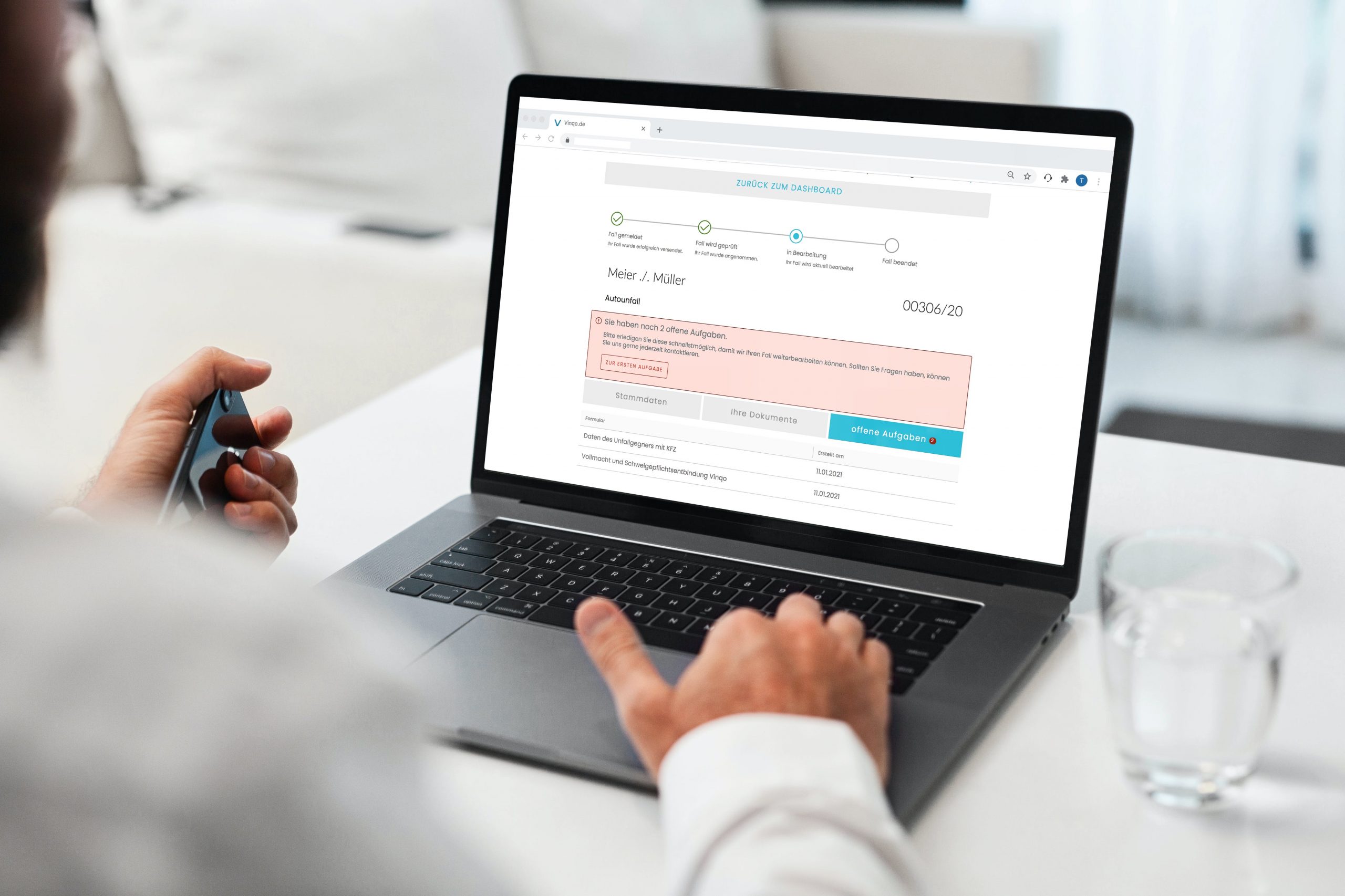

Tim Platner, ist Jurist und Geschäftsführer der Legal Data Technology GmbH, die mit VINQO.DE Deutschlands erste Legal-Tech-Plattform für Schadensfälle entwickelt.